Набор возможностей: GeForce RTX 2080 Ti

Свое дело сделали и ощущение новизны после долгого простоя, и максимально позитивная презентация, и новые технологии, и ценовой аспект. Мнения, обзоры и «экспертные оценки» сыпятся месяца полтора, и лишь сейчас огонь под кастрюлькой ослаб и кипение поутихло. Самое время подытожить увиденное, услышанное и прочитанное, попутно составляя собственное мнение о продукте.

Про свет, отражения и сглаживание

Можно сказать, что GTX 2080Ti – по-настоящему ожидаемая видеокарта. Ещё бы, почти два года от NVIDIA не было ни одного по-настоящему сильного продукта в настольном сегменте. Единственный стоящий внимания момент – выпуск GTX 1070 Ti для удобной конкуренции с Vega 56, представленной в прошлом году. И вот, в августе анонсируются новые видеокарты на архитектуре Turing. Говорят, что первая партия так и не легла на полки магазинов, вся разошлась по предзаказам.

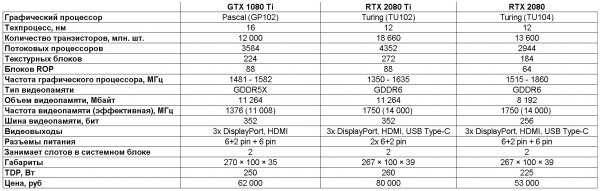

Видеокарт на данный момент три – RTX 2080 Ti, RTX 2080 и RTX 2070. Расстановка сил осталась неизменная – самая производительная 2080 Ti, основанная на старшем TU102, за ней идет 2080 на TU104 и замыкает тройку 2070 на TU106. Откуда в кодовом названии графических процессоров взялись буквы TU, понятно сразу (сокращение от Turing). Со сменой GTX на RTX все сложнее, даже длинная презентация Дженсена Хуанга (Jensen Huang), президента NVIDIA, проясняет не все детали. Море красивых картинок, довольный мистер Хуанг и ликующая публика. Особенно эмоционален зал при объявлении цены – 499 баксов за 2070 (у нас около 40 000 рублей со всеми налогами). За что такие деньги?

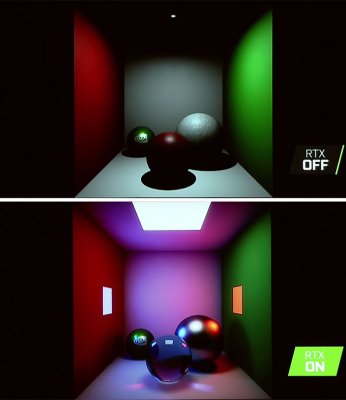

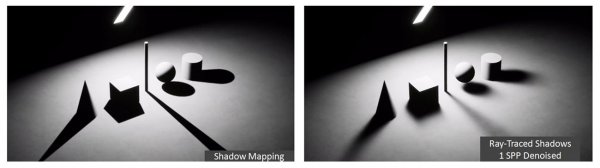

В основном за хардварную трассировку лучей в реальном времени. Собственно, R от неё взята (ray tracing). Лучи отвечают за освещение (его реалистичность) и отражения в игровом 3D мире. Это не новинка, «изобретены» они ещё в прошлом веке, но применение их ограничивается сложностью реализации – просчет требует значительных вычислительных мощностей. В современных играх для создания реалистичного освещения применяется растеризация, отражения «рисуются» с помощью карт окружения. Картинка получается достоверная, но переход к расчетам лучей позволит сделать освещение и отражения совсем как в реальной жизни. Презентация Дженсена изобиловала сравнениями, только вместо слов «было – стало» писали «RTX ON – RTX OFF».

Разница огромная. В существующих играх, способных, по словам разработчиков, просчитывать освещение «новым» методом (нет), разницу приходится выискивать.

Если не акцентировать внимание на освещении, я бы ничего не заметил. Да, играл в Shadow of the Tomb Raider на GTX 2080 Ti и wow-эффекта не испытал. Просчет света реалистичнее, но не более того. Провал? Нет. Видеокарты только вышли, и игроделам нужно время, чтобы задействовать новые возможности в своих проектах. NVIDIA это, конечно же, понимает, и обещает поддержку трассировки лучей в Assetto Corsa Competizione, Atomic Heart, Battlefield V, Control, Enlisted, Justice, JX3, Mechwarrior V: Mercenaries, Metro Exodus, Project DH.

Многообещающе выглядит Metro, а мне, как фанату серии, понравилась реализация трассировки лучей в Mechwarrior.

https://youtu.be/fbbqlvuovQ0 https://youtu.be/31_xMpNT-cE Чтобы подстегнуть воображение, можно посмотреть технодемку Reflections Real на движке Unreal Engine.

https://youtu.be/J3ue35ago3Y В общем, выводы о рациональности вложений в новые видеокарты прямо сейчас ради лучей делать рано, но наобещали чуть ли не фотореалистичные игры. Если иллюстрировать личные впечатления от увиденного на презентации одной картинкой, я без колебаний выберу эту:

Вместе с лучами подъехал и новый алгоритм полноэкранного сглаживания – DLSS. Расшифровывается сокращение как Deep Learning Super Sampling, но к реальному суперсэмплингу эта штука отношения не имеет. Почти. Суть в том, что новый графический процессор хорошо подходит для работы с искусственным интеллектом, который в играх может улучшать изображения после предварительного обучения. Тренировки сводятся к загрузке множества (счет идет на тысячи) изображений, для которых применяется честный суперсэмплинг, после чего ИИ на ходу сглаживает лесенки и делает мелкие детали изображения более четкими.

Есть даже специальный режим DLSS 2x, когда весь кадр рендерится в меньшем разрешении, а потом силами ИИ доводится до «оригинала». Этакий суперсэмплинг наоборот, идентичный натуральному. Плюс очевиден: меньше ресурсов тратится на отрисовку каждого кадра, повышается частота кадров без потери качества изображения. Минус у этого алгоритма на сегодняшний день один – для корректной работы требуется поддержка со стороны разработчика игры. Обещают поддержку умного сглаживания в 25 играх, среди которых Atomic Heart, Darksiders III, Final Fantasy XV, Hitman 2, Mechwarrior V: Mercenaries, Serious Sam 4: Planet Badass, Shadow of the Tomb Raider, PUBG

Turing в деталях

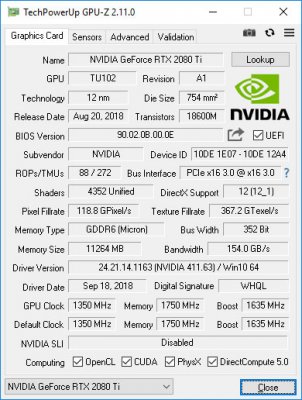

Теперь немного о самом графическом процессоре, который обеспечивает работу всех наворотов с лучами, ИИ и псевдо-сглаживаниями.

По количеству транзисторов TU102 отличается от GP 102 (1080 Ti) существенно – 18,6 миллиардов против 12, что повлекло увеличение площади кристалла на 60%.

На первый взгляд общая архитектура GPU изменилась не сильно – все те же CUDA-ядра, сгруппированные в мультипроцессоры (SM), которые в числе 12 штук составляют GPC (Graphics Processing Cluster). В него также входят шесть TPC (Texture Processing Cluster).

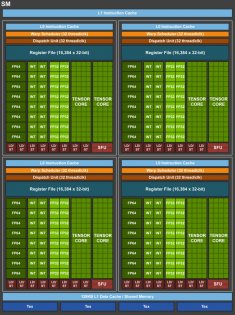

Основной «кирпич» этой матрешки – мультипроцессоры (SM). В каждом из них 64 CUDA-ядер (их же называют потоковыми процессорами или универсальными процессорами), 8 тензорных ядер, блок трассировки лучей (RT Core), 4 текстурных блока, 96 Кбайт КЭШа, 256 Кбайт регистрового файла.

Для сравнения – тот же блок из GP102. 128 CUDA-ядер, 4 текстурных блока, 48 Кбайт КЭШа, 256 Кбайт регистрового файла.

В одном SM вдвое больше CUDA-ядер, но один GPC у GP102 вмещает существенно меньше SM. Так и получает бОльшее общее число CUDA-ядер при том же количестве GPC. Вот структурная схема GP102 для наглядности.

В целом SM у GP102 и TU102 как-то сильно отличаются. А если поставить рядом SM от TU102 и GV100 (Titan V), то адаптация профессионального решения под «конечного пользователя» становится более понятной.

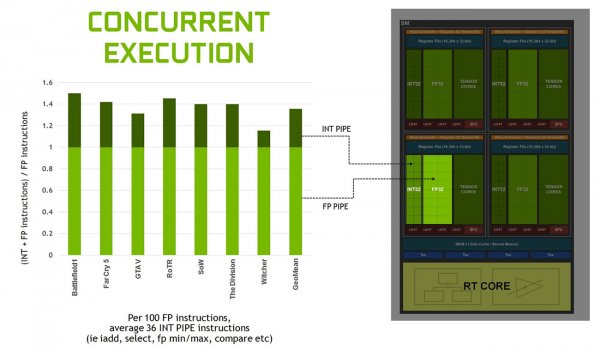

Убрали большинство блоков для операций с двойной точностью (FP64), добавили RT Core. Все? Да, но не совсем. CUDA-ядра из GP102 в TU102 (а изначально в GV100) «разбиты» на блоки FP32 и INT32, поэтому соответствующих инструкций и операций за такт выполняется вдвое больше. В GP102 одновременно исполнять целочисленные операции (INT) и с плавающей точкой (FP) не получалось. На производительность в играх это должно повлиять самым прямым образом, так как, по словам NVIDIA, на 100 операций с плавающей точкой приходится 36 целочисленных.

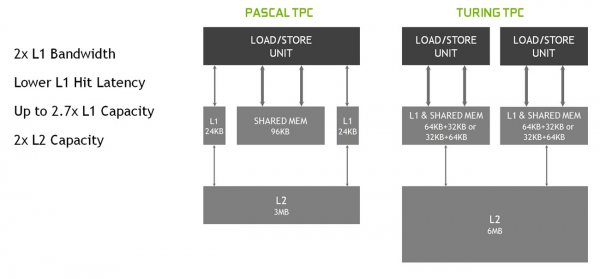

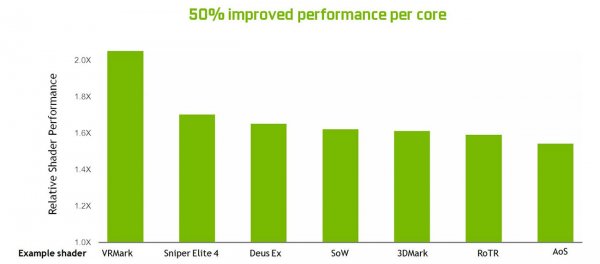

Доработали алгоритм кэширования, объединив кэш L1 и разделяемую память. Это позволило снизить задержки, увеличилась пропускная способность и емкость КЭШа.

Появился кэш L0 для инструкций, в каждом TPC (Texture Processing Cluster, объединяет два SM) удвоили объем КЭШа L2. Все эти доработки, по заверениям Nvidia, увеличили производительность в играх на 50 и более процентов.

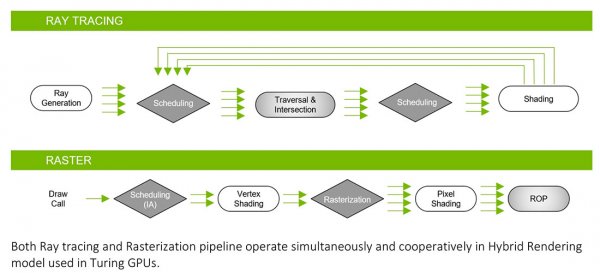

Блоки RT Core специально предназначены для ускоренного просчета трассировки лучей. Ниже – схематичное сравнение просчета освещения методом растеризации и трассировки лучей.

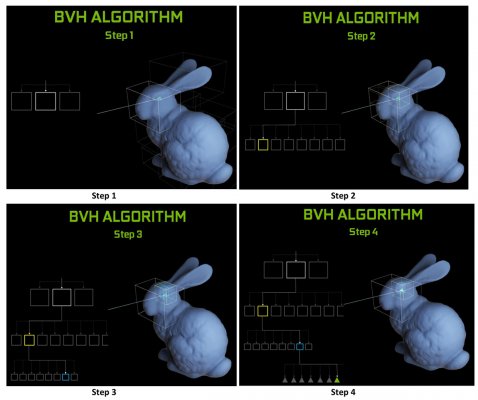

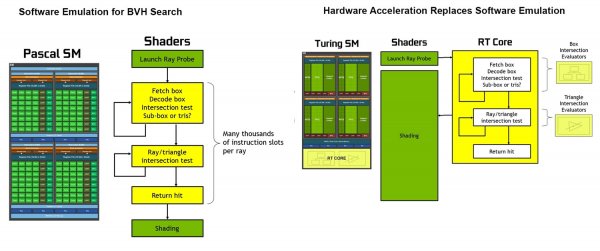

RT Core определяет пересечения лучами полигонов, при этом используется алгоритм BVH (Bounding Volume Hierarchy). Суть его в том, что сцена разделяется на ограниченные объемы, которые «обрабатываются» по очереди.

GP102 может «обрабатывать» лучи также то же, но гораздо медленнее, затрачивая больше процессорного времени за отсутствием специализированного блока.

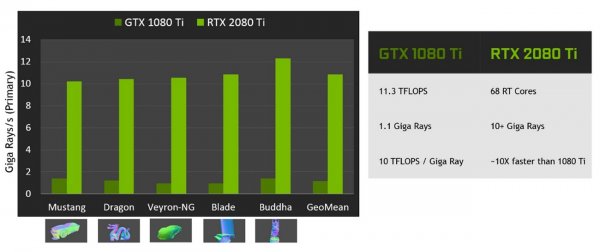

Производительность 2080 Ti определили в 10 гигалучей за секунду, но пока сравнивать не с чем, да и параметр этот, похоже, такой же теоретический, как IOPS в бенчмарках – от архитектуры процессоров к архитектуре параметр прыгает чуть ли не в разы, а на практике нужны сильно специализированные задачи для повторения подобного «успеха». Но демонстрировать такие графики, безусловно, очень приятно для производителя. Вот и Nvidia не удержалась.

Наиболее выразителен эффект от перехода на трассировку при создании мягких теней, глобального освещения, отражений. Особенно отражений тех объектов, что находятся «вне сцены» и не видны игроку; их без трассировки вообще не просчитать. Возможности для разработчиков открываются огромные, картинка в играх может поменяться до неузнаваемости одной «правильной» работой со светом. Но игры эти, как уже говорилось, надо сделать, а пока блоку RT проявить себя негде. Демки не в счет, там коопчик не погонять, сингл не пройти, раз на раз не порубиться.

Значительную часть каждого SM занимают тензорные ядра (Tensor Core), предназначенные для ускорения работы нейронных сетей, или, по-простому, искусственного интеллекта (ИИ). Тензорные ядра специализируются на операциях перемножения матриц данных, вычислениях с плавающей запятой. Если операции проводятся целыми числами, то производительность ядер увеличивается в 2-4 раза.

Важно, что при этом практически не используются остальные блоки, а сами тензорные ядра занимают сравнительно малую площадь кристалла. Последнее особенно актуально из-за специфичности тензорных ядер – иные операции (кроме работы с матрицами) они выполняют медленно. По первым прикидкам получается, что в играх простаивают тензорные ядра, при работе ИИ – остальные. Но нет. Если тема с DLSS (который задействует как раз тензорные ядра) «не пойдет», то можно приспособить ИИ для расчета AI, и NPC (они же боты) в играх будет в кои-то веки умнее барана. Плюс, ядра могут помогать «облагораживать» картинку после расчета лучшей. Принцип тот же, что в DLSS – посчитаем мало лучей, пройдемся фильтром и будет красиво.

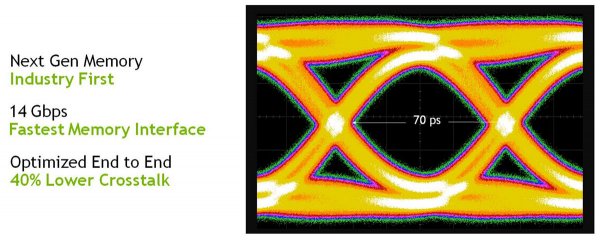

Все графические процессоры Turing поддерживают видеопамять GDDR6. Её пропускная способность составляет 14 Гбит/сек, она на 20% выигрывает по энергоэффективности у GDDR5X. Шина памяти на TU102 384 бита. У 2080 Ti, правда, порезана до 352 бит из-за одного отключенного контроллера. Дабы не загружать расчетами, приведу теоретическую пропускную способность памяти для 1080 Ti и 2080 Ti – 484 и 616 Гбайт/сек соответственно. Разница – 27%, что должно положительно сказаться на производительности. Видеокарты Nvidia некоторых прошлых поколений проигрывали в высоких разрешениях одноклассникам от AMD/ATi в том числе из-за узкой шины памяти. Надеюсь, это в прошлом, и широкая шина, два независимых 16-битных канала и стабильная работа на высоких частотах не будут «душить» GPU нехваткой данных.

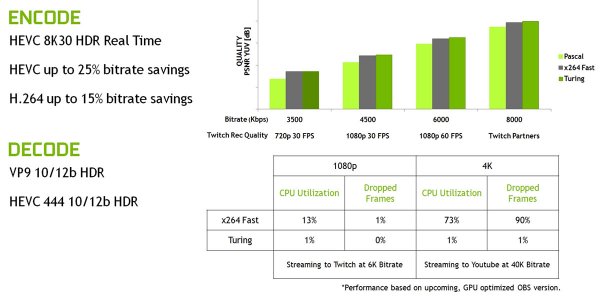

Доработанный кодировщик видео NVENC поддерживает сжатие в формате H.265 и способен обрабатывать видеопоток 8K при 30 кадрах в секунду. Другие улучшения позволяют экономить до 25% битрейта при работе с H.265 и 15% при работе с H.264 с сохранением качества.

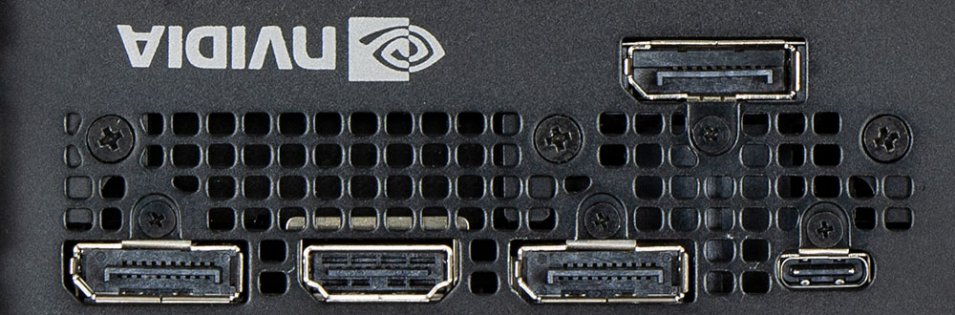

Выводить изображение можно на два 8K экрана при частоте 60 Гц на каждом, те же 8K можно получить с разъема VirtualLink. HDR поддерживается как со стандартным динамическим диапазоном, так и с расширенным.

Пожалуй, этого теоретического блока хватит для общего понимания ситуации. Я кратко описал лишь основные моменты, сдобрив своими комментариями. Неосвещенными остались наработки по DirectX12, шейдерная модель mesh shaders, Variable Rate Shading (VRS), NVLink. Про каждому нововведению можно делать свой отельный материал с практическими примерами, там есть на что посмотреть. Далее – о железе, о GeForce RTX 2080 Ti.

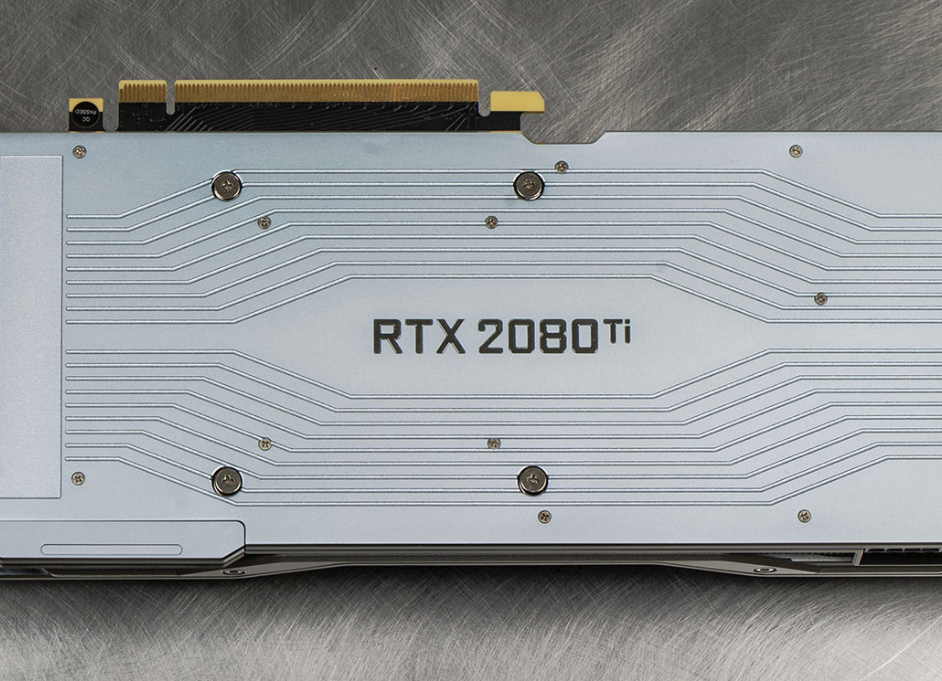

Видеокарта RTX 2080 Ti

Nvidia решила кардинально поменять дизайн своих карт Founders Edition и ушла от традиционного кулера «длинный радиатор с турбиной» к более тихой «тихоходные вентиляторы на радиаторе».

Цветовая схема прежняя – сочетание черного и серебристого, по материалам — металл и пластик.

На черном фоне поблескивает название модели.

Надпись «GeForce RTX» светится ярко-зеленым при включении системы.

В руке видеокарта лежит монолитом, что является косвенным признаком хорошей подгонки всех деталей друг под друга. Обратная сторона защищена металлической накладкой с бортами.

Они практически полностью скрывают печатную плату, предотвращая загрязнения и механические повреждения.

Доппитание подается через два восьмипиновых разъема – аппетиты у 2080Ti немалые, производитель заявляет 280 ватт TDP

Крепежная планка выглядит необычно за счет окраски в матовый черный цвет.

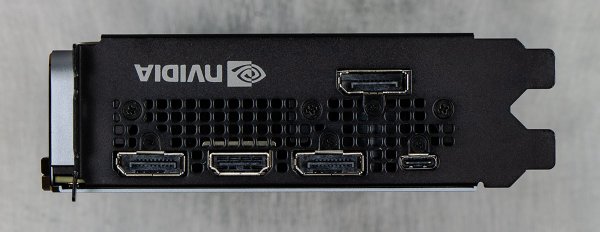

Из видеовыходов остались три DisplayPort (1.4a) и один HDMI (2.0b), а вместо DVI теперь красуется VirtualLink. Он гораздо меньше и внешне напоминает USB 3.1 Type-C. Через этот разъем предлагается подключать шлема виртуальной реальности. Для этого помимо USB на разъем выведены четыре линии DisplayPort (High BitRate 3). Демонтировать систему охлаждения за нехваткой времени не стал. Впрочем, ничего принципиально нового там нет: тепло от графического процессора передается в испарительную камеру, которая распределяет его по нескольким десяткам ребер. Ребра напаяны поперек платы, и нагнетаемый парой вентиляторов воздушный поток выдувается сверху и снизу платы.

От выброса нагретого воздуха за пределы корпуса через решетку в планке крепления почему-то отказались, хотя выштамповать отверстия между разъемами не забыли.

Продувают ребра два вентилятора диаметром 85 мм

Микросхемы памяти, силовые элементы цепей питания охлаждаются через алюминиевое основание кулера, которое накрывает всю печатную плату и снимает большую часть механических нагрузок с текстолита. Кожух на обороте PCB также контактируем с горячими участками платы через термопрокладки, «помогая» кулеру на лицевой части охлаждать электронные компоненты.

Результаты тестов

Для сравнения с RTX 2080 Ti взял самую мощную плату тысячной серии – GTX 1080 Ti. Последняя – от ASUS, версия с гибридной системой охлаждения. По ней выпущен отдельный материал, поэтому останавливаться на её характеристиках не буду.

Производительность новинки оценивалась в восьми наиболее популярных играх.

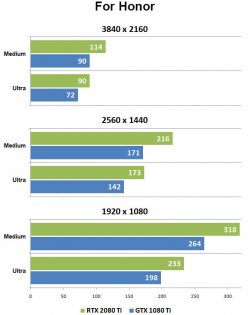

Первой под руку попался экзешник симулятора средневекового гоп-стопа, For Honor.

Он и на 1080 Ti показывает хорошие результаты в 4K разрешении, а 2080 Ti накинула ещё 25%. В итоге — более сотни кадров в секунду при средних настройках качества. На «ультрах» — 90 avg FPS. При переходе к QHD разрыв сократился до 21%, а в FullHD упал до 17% на максимальных настройках качества. Дело явно не в процессоре – работающий на 5 ГГц i7-8700K справляется с загрузкой обеих карт, что явно видно по расстановке сил: при снижении качества 2080 Ti ещё на 3-5% увеличивает отрыв от 1080Ti.

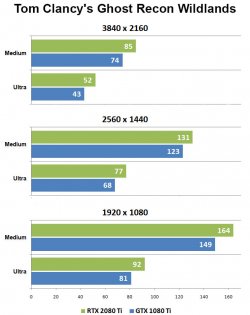

Далее – одна из самых неоптимизированных и тяжелых игр, Tom Clancy's Ghost Recon Wildlands.

Тот случай, когда 50 средних fps в 4K на «ультрах» – успех для самой мощной игровой одночиповой видеокарты. Разница между прошлым и нынешним флагманами в 4K от 14 до 20%, в QHD от 6 до 13%, в FullHD от 10 до 13%. Чем ниже разрешение, тем больше прибавка кадров в секунду от одного движения ползунка качества. Субъективно разницы между двумя Ti нет: что первая, что вторая одинаково хорошо (или не совсем хорошо, как в 4K) справляются с задачей.

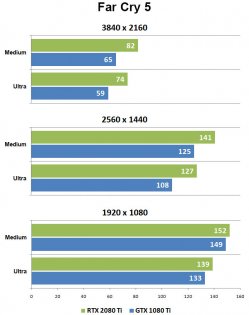

Похожие результаты в FarCry 5, только прибавка fps от смены качества картинки не так заметна.

RTX опережает GTX на 25% в 4K,13-18% в QHD, и всего на 3-4% в FullHD. Похоже, тут все-таки уперлись в процессор, а реально тяжелым для видеокарт оказалось лишь 4K разрешением, причем независимо от качества картинки.

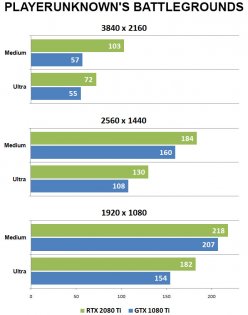

В PLAYERUNKNOWN'S BATTLEGROUNDS самые нестабильные результаты.

Разница в результатах на 4K варьируется 31 до 81%! Возможно, это следствие особенностей игрового процесса, когда изображение на полсекунды-секунду подтормаживает, а рефреш падает до фиксированных 30 fps. Демка для снятия результатов подбиралась по минимальной вероятности подобных финтов, но в тяжелом для видеокарты режиме полностью их избежать не получается. Глазом видны не все, лучше всего их смотреть на графике в Fraps bench viewer.

В QHD и FullHD результаты более стабильны, разница в производительности видеокарт колеблется от 15 до 20% и от 5 до 18% соответственно. Упор в процессор случился на средних настройках в FullHD, этот потолок в 218-220 кадров виден хорошо.

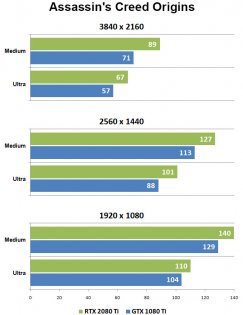

Следующая игра – Assassin's Creed Origins – известна умением работать с современными многоядерными процессорами.

В данном случае «работать» означает явную реакцию не только на тактовую частоту, но и на отключение ядер. Тем не менее, явного потолка по аналогии с PUBG не видно, зато хорошо проявляются конструктивные преимущества Turing. В 4K 2080 Ti производительнее предшественницы на 18-25%, и максимальный отрыв приходится на средние настройки качества изображения. В QHD разница меньше, 12-14%, и в FullHD снова подобная ситуация: 1080 Ti слабее на 9% при средних настройках качества и на 6% -– при высоких. Причина, видимо, кроется в «заводских» наборах настроек для каждого пресета качества.

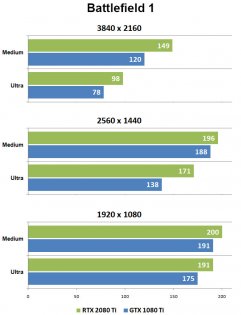

«Процессорный потолок» вроде бы заметен и в Battlefield 1, он по факту проявляется ограничение в 200 fps.

Приближение к ограничителю видно и в QHD – 4% разрыва на средних настройках и аж 24 на высоких. «Истинная» расстановка сил проявляется в 4K, где ни процессор, ни другие ограничители не мешают. 24-25% разницы между флагманами двух поколений независимо от настроек качества.

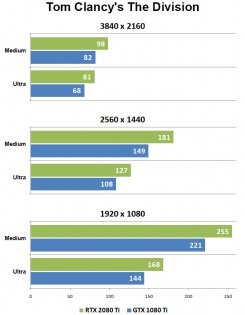

В Tom Clancy's The Division рефреш сильно изменяется с ростом разрешения, тогда как изменение качества в 4K – самом тяжелом для видеокарт разрешении – повлияло заметно меньше.

2080 Ti быстрее на 19% в 4K, на 17-21% в QHD и на 15-16% в FullHD. Показатели стабильные, ни одного «подозрительного» прохода во время тестов. Даже добавить нечего.

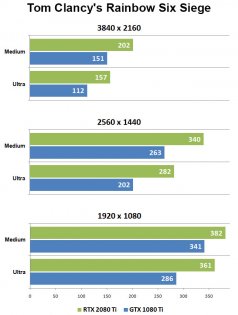

Третья игра Тома Клэнси в списке – Tom Clancy's Rainbow Six Siege – отличилась неожиданно высокими показателями во всех разрешениях.

После тяжелых Division и Wildlands такая картина кажется странной. И производительность видеокарт отличается значительно: 34-40% в 4K, 30-40% в QHD, 12-26% в FullHD. Видимо, 382 кадра и 12% случились по вине процессора, и будь он по шустрей, четыре сотни avg fps покорились бы на раз. Повторяемость результатов от прохода к проходу высокая, разброс показателей менее 3%, так что считаем цифры справедливыми.

По итогу выходит, что RTX 2080 Ti быстрее GTX 1080 Ti на 10-25% в зависимости от игры. Хороший прирост при смене поколений видеокарт, процессорам Intel такие «пропасти» могут только снится.

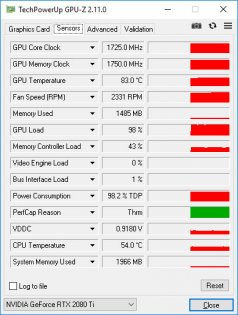

Частоты под нагрузкой получились следующие: 1725 МГц GPU, 1750 (14 000) МГц памяти. Авторазгон под нагрузкой действует неплохо, 90 МГц сверх официального максимума.

Температура графического процессора поднималась до 83 градусов, радиатор и задняя стенка прогрелись до 66 градусов.

Нагрев плавный, без резких скачков, и так же хорошо заметно снижение тактовой частоты видеопроцессора при росте температуры. Вывод простой: хотите максимальной производительности – применяйте эффективное охлаждение. Можно, воспользоваться преимуществами GPU Boost 4.0, которая позволяет либо в ручном, либо в автоматическом режиме поискать предел стабильной частоты графического процессора.

Новая система охлаждения, как и ожидалось, тиха. За тяжелой стенкой из 0,85 мм металла видеокарту едва слышно под нагрузкой. На открытом стенде уже с трех метров шелест лопастей сливается с общим шумовым фоном процессорного кулера и прочих вентиляторов. Судя по спецификациям на последние, крутиться более чем на 2450 оборотов они не способны, а для эффективной продувки такого радиатора больше подходит злая турбина на десятка два-три ватт, способная набрать тысяч 5-6 оборотов. Но тогда она не будет столь тихой, а пользователь готов на многое ради тишины, даже на сброс частот.

Подведём итоги

RTX 2080 Ti определенно удалась и может с честью носить звание флагмана как минимум год. Полезные нововведения в Turing дают разработчикам новые возможности, которые предстоит осваивать не один год, приближая качество 3D картинки в играх к фотореалистичной. Но на данный момент многие из этих фич (в первую очередь трассировка лучей) бесполезны, так как нигде не используются. С новым Tomb Rider больше вопросов, чем ответов, и говорить о реализации Ray Tracing в ней я не берусь.

На данный момент мы имеем 15-25% прироста производительности при разнице в цене более 65% (51 000 рублей за 1080 Ti и 85 000 рублей за 2080 Ti на момент написания материала). Покупать флагмана двухтысячной серии невыгодно… Для игр.

Если же абстрагироваться от забав и рассмотреть другие применения вычислительных мощностей новинки, то в «рабочей» среде могут пригодиться тензорные ядра, а по этой теме конкурент у 2080 Ti только один –Titan V, который в разы дороже. Да и денежные расклады уже другие, и вложенные в новинку десятки тысяч рублей могут быстро отбиться при эффективном её использовании. Это хорошо, потому как тупик уже хорошо чувствуется – год сменяется годом, рядом с надписью Windows сменяются циферки, а реально прорывных технологий так и нет. Как сидели за плоским экраном 15 лет назад, топча клаву, так и сидим. Может, подобные «железные» возможности таки придадут «бытовому» прогрессу ускорение?..

Неюо есть пара-тройка неприятных моментов:

> На первый взгляд общая архитектура GPU изменилась не сильно

А затем, буквально абзац спустя, рассказывается, что карту полностью перелопатили

> Не упомянули улучшения API и ассинхронников — и то, и то люто апнули, из чего следует, что...

> нет теста нормальных игр и игр на вулкане

Увы, но помойке на DX11 давно место в музее и лишь консоли не дали кануть сему мусору в забвение

А DX12_1 — один из тех самых API, которые хорошо в веге и тьюринге, но плохо в паскале и полярисе. Тут разница будет на лицо

А вулкан и ассинхронники — тут все сказано, в вульфе RTX 2070 пинает GTX 1080 Ti

> *фраза про игорь тонет*

Есть. BFV и Minecraft. В BFV с реализацией слились и вышла кака, а в майнкрафте нужно найти шейдер (континуум подойдет) с трассировкой пути (path tracing, лучше, чем ray tracing) и ресурспак с спекулярной и нормальной картой высокого разрешени я (POM + PBR), после чего запастись ОЗУ и скрестить пальцы

В итоге выйдет игра графонистее, чем любая АААшка, и обладающая 4К 60 фпс с трассировкой на 2070

«На первый взгляд общая архитектура GPU изменилась не сильно»

> нет теста нормальных игр и игр на вулкане

Например? Что есть «нормальная игра»? Если будут достойные кандидаты (а не те, в которые играет полтора человека), то внесу в список тестовых приложений. Нынешний список определяется преимущественно предпочтениями игроков. Стимовские статистики и т.д.

> BFV с реализацией слились и вышла кака

> в майнкрафте нужно найти шейдер <...> и ресурспак с спекулярной и нормальной картой высокого разрешени я (POM + PBR), после чего запастись ОЗУ и скрестить пальцы.

Итого получаем *фраза про игорь тонет*

Варианты с «я получил графонистость утопив сто урановых ломов в ртути» не рассматриваются. Они хороши с академической точки зрения, поучиться там, потрениться в левел-дизайне или ещё чем. А практический интерес покупателя к ним такой же, как к концептам или кастомам на выставках — поохать, поцокать и пойти в кассу оплачивать что-то рядовое-конвеерное.

Покупать такую вещь, чтобы потом она артефачила)

Собственно говоря, именно сочетание плохого нерефа и ультраубогого бп, который в наши дни сложно найти, спосоьны дать бабах у питалова. Способ актуален для любых видеокарт выше уровня «затычки»

Так что минус Вам, мсье, за дезинформацию. Кстати, рендер на WebGL — тоже «работа в браузере»