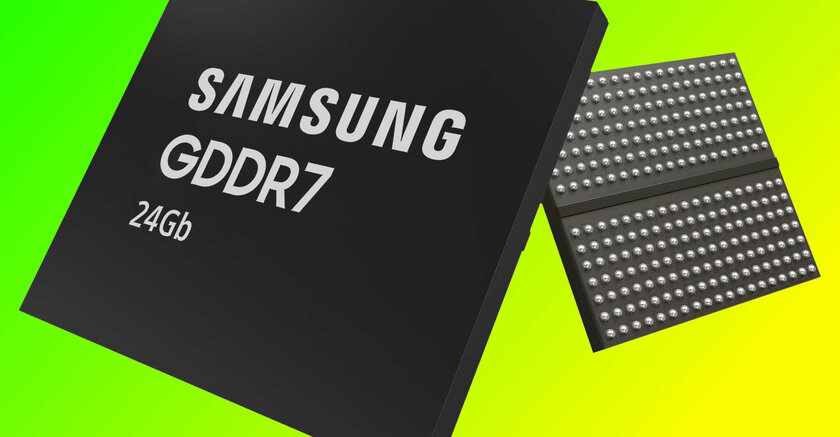

Samsung представила память GDDR7 колоссального объёма: её могут использовать в RTX 5090

Сегодня, 17 октября, компания Samsung официально представила миру свою новую память GDDR7 повышенной ёмкости, которая в будущем будет использоваться как в видеокартах, так и в центрах обработки данных. Стоит отметить, что если в GDDR6-памяти производитель использовал чипы на 8 Гб (1 ГБ) и 16 Гб (2 ГБ), то теперь речь идёт о чипах GDDR7 объёмом 24 Гб, то есть на 3 ГБ памяти каждый. В Samsung уже заявили, что это самая ёмкая память, которую компания когда-либо разрабатывала для графических ускорителей, и она позволит увеличить объём встроенной видеопамяти при сохранении того же количества чипов на печатной плате.

Например, ранее видеокарты с четырьмя чипами GDDR6 были ограничены объёмом в 8 ГБ видеопамяти, потому что максимальный объём на один чип составлял 2 ГБ. Теперь же производители могут разместить столько же чипов, но получить уже 12 ГБ видеопамяти (но только в том случае, если видеокарта поддерживает GDDR7). Кроме того, представители производителя заявили, что их новая память использует технологический процесс в 10 нм и обеспечивает повышение плотности памяти на 50% при сохранении физических размеров чипа, как и в поколении GDDR6. Более того, у свежих чипов скорость передачи данных тоже выше.

В Samsung отметили, что их память демонстрирует скорость передачи данных на уровне 40 Гбит/сек, но в будущем её можно будет улучшить и до 42,5 Гбит/сек. Стоит напомнить, что самая быстрая память в серии RTX 40 демонстрирует скорость на уровне 22,4 Гбит/сек, но это вовсе не значит, что RTX 50 будет в два раза быстрее по памяти. Ранее возникали слухи, что RTX 5090 будет работать на скорости в 32 Гбит/сек — это всё ещё заметно быстрее предшественника, но не дотягивает до максимально возможных скоростей GDDR7. Это, возможно, связано с ограничениями шины памяти в видеокарте или с желанием NVIDIA оставить задел для апгрейда на будущее.

При этом GDDR7 с новым объёмом позволит компании выпустить RTX 5090 с объёмом 36 ГБ (при 384-битной шине) или даже 48 ГБ (в случае 512-битной шины), что, безусловно, является значительным шагом вперёд на фоне RTX 4090 с 24 ГБ видеопамяти. На текущий же момент Samsung сообщила, что новая конфигурация памяти сейчас проходит проверку основными клиентами рынка видеокарт, а полноценное серийное производство планируют запустить уже в 2025 году. Соответственно, ждать запуск RTX 5090 в начале года точно не стоит — просто не успеют выпустить чипы.

а так да, идея хорошая

Штуки для энтузиастов, это, конечно, хорошо. Но много ли человек их купят?

Просто пока что 40-я ощущается экспериментальной, так же как 20-я, когда она только появилась. Видеокарт нижнего ценового сегмента нет, видеопамяти столько же или даже меньше, но зато новую технологию предложили, которую использовать начнут далеко не сразу и не все.

Более того, хотя RTX 4090 продавалась по конским ценам уровня 2500+ долларов, её всё равно покупали и она была в дефиците, так что, видимо, энтузиастов предостаточно :) Особенно на фоне возможности запускать LLM локально на ПК для работы с большими данными

По поводу экспериментальности не соглашусь — видеокарт доступного уровня нет, потому что выпускать их не то чтобы выгодно)) а DLSS используют повсеместно — почему же не все и не сразу?