Microsoft разработала новую систему защиты: она «отлавливает» галлюцинации в ИИ-приложениях

Кратко:

- Microsoft внедряет новые функции безопасности для обнаружения уязвимостей и мониторинга галлюцинаций, которые возникают в ИИ-приложениях на платформе Azure.

- Компания представила три новых инструмента — для блокировки вредоносных команд, фильтрации галлюцинаций и оценки безопасности.

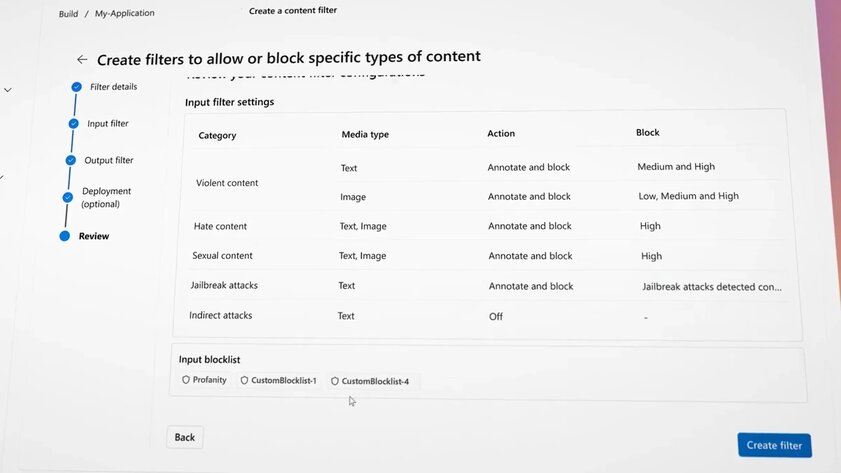

- В инструменты безопасности встроена возможность регулировать фильтры содержимого (включая ненависть и насилие), плюс в будущем будет возможность получить отчёт о пользователях, пытающихся инициировать ввод подобных данных.

Сегодня, 29 марта, информационное издание The Verge со ссылкой на Сару Берд (Sarah Bird), ведущего сотрудника в области искусственного интеллекта компании Microsoft, сообщило, что команда разработчиков IT-гиганта создала несколько совершенно новых функций безопасности, которые позволят существенно упростить жизнь клиентам сервисов Azure, не желающих нанимать специалистов для проверки созданных ими сервисов на базе ИИ. Сотрудница Microsoft заявила, что новые инструменты на базе больших языковых моделей могут обнаружить потенциальные уязвимости новых сервисов, отслеживать галлюцинации нейросетей, а также блокировать вредоносные подсказки в режиме реального времени.

«Мы понимаем, что не все наши клиенты обладают глубокими познаниями в области атак посредством внедрения подсказок или неподобающего контента, так что наша система оценки генерирует подсказки, необходимые для моделирования такого рода атак. Клиенты могут получить оценки их продукта и увидеть результаты», — объяснила Сара Берд.

Вероятно, это позволит избежать различных споров о генеративном искусственном интеллекте, которые вызваны нежелательными действиями в отношении нейросетей. Например, это касается подделок видео или фото со знаменитостями посредством генератора изображений Designer от Microsoft, создания исторически неточных изображений через Google Gemini и прочих неприятных моментов.

Для того, чтобы избежать подобных сценариев, команда из Microsoft разработала сразу три функции, повышающие безопасность работы клиентских сервисов на базе ИИ:

- Prompt Shields — инструмент для блокировки инъекций вредоносных подсказок из внешних документов, которые инструктируют большие языковые модели идти против их протоколов обучения.

- Groundedness Detection — инструмент, позволяющий найти и заблокировать галлюцинации нейросети.

- Safety Assessments — система, которая оценивает уязвимость моделей.

Соответственно, независимо от того, вводит ли пользователь подсказку или модель обрабатывает сторонние данные, новая система мониторинга будет оценивать введённые данные на предмет наличия запрещённых слов или скрытых подсказок, а только после этого принимать решение об отправке нейросети для ответа. Кроме того, система будет просматривать ответ модели и проверять, не галлюцинировали ли она при выдаче информации. Правда, насколько такая система нагружает систему и увеличивает время ожидания, в Microsoft не уточнили.