Т-Банк представил LLM с гибридным режимом рассуждений: модель обходит Qwen3 и DeepSeek R1

Сегодня, 18 июля, российская технологическая компания «Т-Технологии» официально представила свою первую большую языковую модель с поддержкой гибридного режима рассуждений под названием T-Pro 2.0. Основное преимущество подобных LLM в том, что они могут давать быстрые ответы на простые вопросы или заниматься глубокой аналитикой в случае тяжёлых запросов, позволяя существенно снизить расходы при внедрении искусственного интеллекта в реальные проекты. И, что немаловажно, российская компания создала свою модель с относительно небольшим бюджетом — представители бренда заявили, что общие расходы на разработку T-Pro 2.0 составили всего 120 миллионов рублей.

Представители компании отмечают, что подобные большие языковые модели отлично справляются со сложными задачами, требующими глубокой аналитики, так что такие LLM можно считать условной технической базой для создания передовых ИИ-агентов, которые могут взаимодействовать с различного рода интерфейсами и выполнять поставленные задачи без участия со стороны специалиста-человека. К примеру, в официальном пресс-релизе указано, что в разделе поддержки ИИ-агенты могут не просто генерировать ответы на вопросы клиентов, но и решать определённые вопросы без необходимости подключать к задаче оператора. В «Т-Банке» на данный момент доля обращений, обрабатываемых таким образом, уже составила 45%.

Кроме того, благодаря поддержке «рассуждений» российская большая языковая модель научилась планировать действия, выдвигать гипотезы и самостоятельно их же опровергать, а также структурно рассуждать над решением вопроса. Это позволило давать LLM более сложные задачи, чем раньше.

«Если раньше моделям можно было дать автономную задачу, на которую в среднем у человека уходит 30 секунд, то моделям с режимом рассуждений можно поручать задачи на которые у человека уходит в среднем 8 минут», — цитата из официального пресс-релиза.

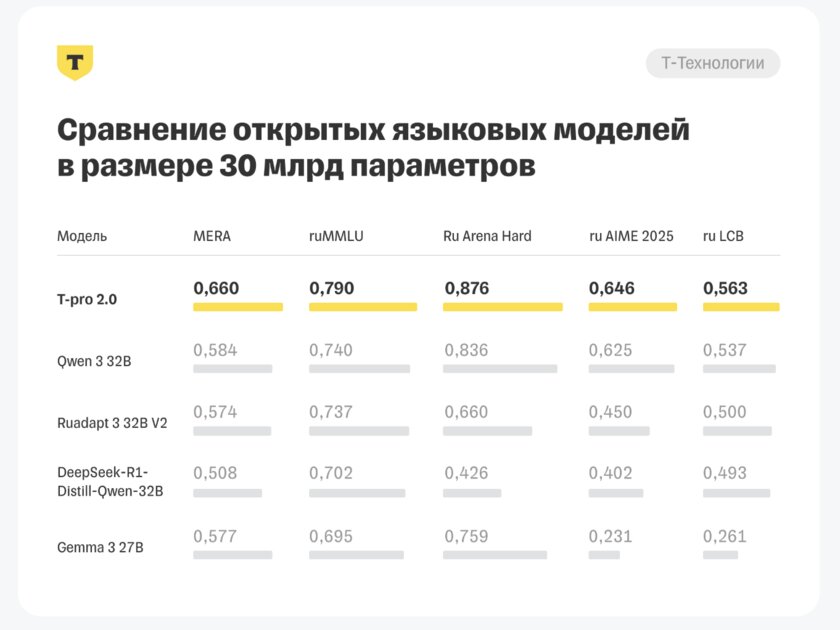

Также представители компании отмечают, что T-Pro 2.0 является лидером в своём классе, так как данная большая языковая модель способна выдавать более качественные ответы, чем другие открытые LLM с 30 миллиардами параметров. Это, без всякого сомнения, огромное достижение.

Правда, стоит уточнить, что преимущество T-Pro 2.0 имеет только в случае с прогоном в русскоязычных бенчмарках MERA, ruMMLU, Ru Arena Hard, ru AIME и ru LCB.