Представлена модель DeepSeek-V3.1: с гибридным режимом и увеличенным контекстным окном

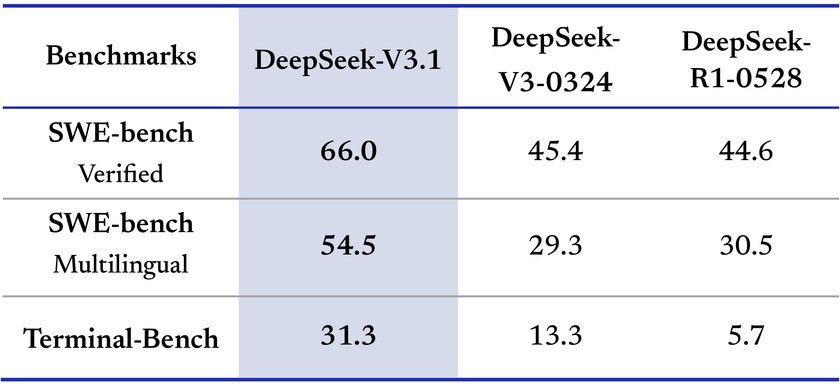

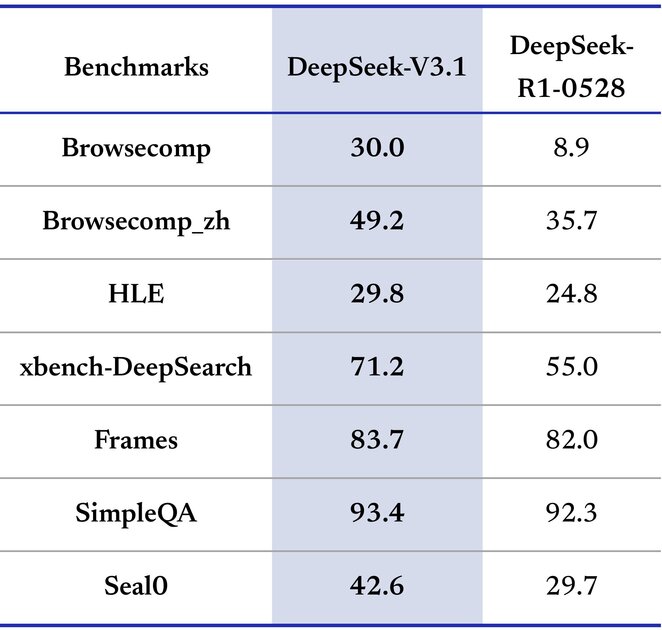

Вчера, 20 августа, китайская компания DeepSeek официально представила миру новую версию своей большой языковой модели под названием DeepSeek V3.1, которая уже доступна на бесплатной основе всем желающим посредством веб-версии чат-бота компании. И новинка пользователей, скорее всего, заинтересует, так как разработчики обещают значительный прирост точности по сравнению с предшественниками и моделями-конкурентами от ведущих компаний мира. Например, в рамках бенчмарка SVG Bench модель DeepSeek V3.1 набрала 53,1% правильных ответов, что выше, чем у Gemini 2.5 Flash, GP5 Chat, A04 Mini Flash Light и Kim K2. А в бенчмарке ADA новая модель вовсе продемонстрировала 71,6% точности.

При этом представители компании отмечают, что новая версия большой языковой модели в 2,5 раза быстрее предыдущей LLM, что, безусловно, играет ключевую роль в сценариях, где помимо точности нужно получать ответ на запрос максимально быстро.

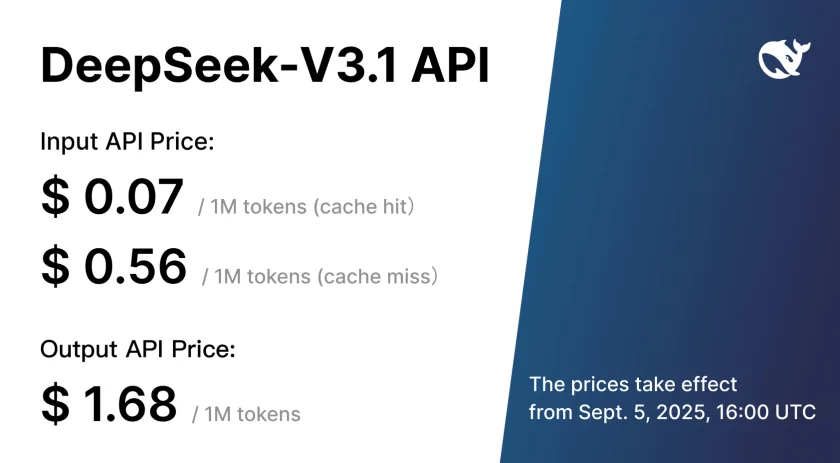

Есть хорошие новости и по вопросу стоимости — в DeepSeek заявили, что DeepSeek V3.1 в 68 раз дешевле модели Claude Opus (правда, разработчики не уточнили версию LLM от Anthropic, с которой проводилось сравнение, но, скорее всего, речь о модели с индексом 4.1), а также на 1% эффективнее. Например, 1 миллион токенов ввода в данном случае стоит всего 0,07 доллара (1,68 доллара за 1 миллионов токенов вывода), плюс в веб-версии чат-бота нет никаких ограничений по количеству запросов.

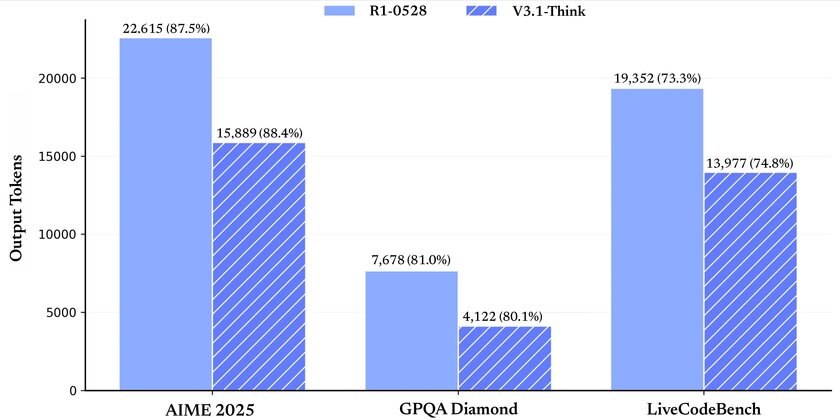

Ещё китайская компания решила в DeepSeek V3.1 удвоить размер контекстного она по сравнению с DeepSeek V3 ровно вдвое — 128 000 токенов против 64 000 токенов. Безусловно, это далеко не рекорд, так как у некоторых моделей имеется контекстное окно на 1 миллион токенов, но это всё равно существенное улучшение, позволяющее обрабатывать гораздо большие объёмы данных, большие документы и сохранять контекст в течение продолжительных диалогов. И, что самое важное, DeepSeek V3.1 поддерживает гибридную архитектуру размышлений — если раньше пользователю приходилось переключаться между «глубоким» и «неглубоким» форматом размышлений, то теперь система переключается автоматически в зависимости от поставленной задачи.

Также китайская компания продолжает следовать идее полной открытости — DeepSeek V3.1 доступна для загрузки на Hugging Face по лицензии с открытым исходным кодом. Это значит, что исследователи и энтузиасты могут использовать модель на 685 миллиардов параметров для своих задач, которые будут выполняться локально.

Скучная ИИ, хотя ответы её не хуже тех, что выжает ЖПТ.

Но хотелось бы уже голосовух как в гроке и жпт, и более широкое взаимодейтвие, а так — дипсик на том же месте где и год назад, к сожалению.